OpenAI kunngjorde nylig sin GPT-4o-modell, en ny flaggskipmodell av motoren som driver ChatGPT, dens berømte AI-drevne chatbot først utgitt i 2022. Denne nyere modellen tar menneske-datamaskin-interaksjon til et helt nytt nivå ved å få det til å virke raskere og mye mer naturlig.

I GPT-4o står «o» for «omni», siden den kombinerer tekst, bilde og lyd til en enkelt modell. Selv om det ikke er noen forbedring i intelligens- og resonnementfronten i forhold til GPT-4 Turbo-modellen, er det mange nye oppdateringer. Den er designet for å gi raskere, mer menneskelignende responser, og kan til og med simulere følelser. Den er også betydelig raskere til å forstå visuelle og lydinnganger. I dette dypdykket skal vi ta en titt på funksjonene som GPT-4o tilbyr, og hvordan det vil revolusjonere måten vi samhandler med AI-assistenter på. Så bli med oss, og la oss komme i gang!

GPT-4o er betydelig raskere

GPT-4o-modellen lar ChatGPT akseptere input i ulike former, inkludert lyd, tekst, bilder eller kombinasjoner av dem. Det kan også gi svar i forskjellige formater. Det som er mest imponerende med det, er imidlertid hastigheten som det gir deg svar.

Med den nye modellen tar ChatGPT bare rundt 320 millisekunder eller enda mindre å svare på lydinnganger, som er nær tiden en person bruker på å svare i en samtale. Utenom dette er ytelsen til GPT-4o lik GPT-4 Turbo når det gjelder bruk av engelsk eller skrivekode.

Den gjør det også mye bedre når den svarer på tekstbasert inndata på ikke-engelske språk, og er betydelig billigere i API-en siden den er mye mer effektiv enn forgjengeren.

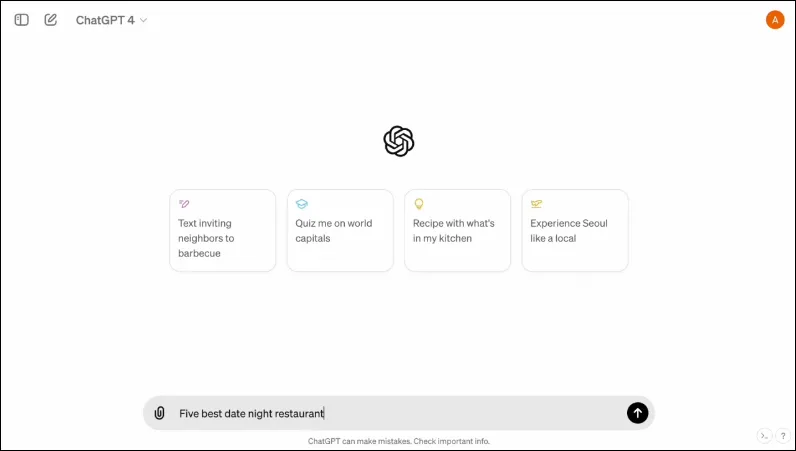

Den har også et nytt grensesnitt, designet for å gjøre interaksjon enklere og ryddigere.

Det er multimodalt

ChatGPTs eksisterende stemmemodus består av tre modeller. Den første tar inn tekstbasert inndata og gir utdata i samme format, mens den andre konverterer lydinndata til tekst, som tas inn av ChatGPT for å gi tekstbasert utgang. Den siste modellen konverterer tekst til lyd.

Imidlertid resulterer dette designet i tap av informasjon siden modellen ikke kan samhandle direkte med lydinngangen eller nåværende utgang som har emosjonelle elementer. Med GPT-4o har OpenAI bygget en enkelt multimodal modell som kan forstå ulike typer input og behandle den nødvendige utgangen direkte.

Den støtter for øyeblikket 50 språk og vil også være tilgjengelig som en API.

Det kan simulere menneskelige følelser

Da ChatGPT først ble annonsert, var en av de største ulempene med AI-chatboten for mange mennesker at den ikke kunne gi emosjonelle reaksjoner. Med GPT-4o kan ChatGPT simulere menneskelige følelser og gi passende svar som integrerer slike følelser.

I demoene som deles av OpenAI, kan chatboten sees ler, synger og til og med vise sarkasme når han blir bedt om det. Dette er ligaer over hva enhver annen AI-chatbot kan gjøre for øyeblikket, og vil gjøre brukerinteraksjoner mye morsommere. I følge OpenAI vil den nye modellen tillate ChatGPT å oppdage brukerens humør også, og gi tilstrekkelige svar basert på den informasjonen.

Kombinert med muligheten til å bruke visuelle input, er muligheten til å gi emosjonelle responser en av de mest imponerende funksjonene som den nye modellen tilbyr.

Den nye modellen kan lagre en større mengde informasjon

Takket være GPT-4o kan ChatGPT nå forstå bilder, som diagrammer og bilder bedre og også lagre mer informasjon om brukeren. Dette fører også til svar som kan inneholde større tekstbiter, noe som kan være nyttig i flere brukstilfeller.

Du kan for eksempel be chatboten om å oversette større tekststykker nå, og det kan hjelpe deg med live oversettelse. Siden den kan bruke visuelle og lydinnganger sammen med tekstbaserte, kan du bruke den til å samle informasjon fra skjermbilder, bilder og andre bilder.

Siden den kan lagre en større mengde informasjon uten at brukerne trenger å gjenta, lar GPT-4o brukere delta i frem-og-tilbake-samtaler med AI-chatboten. Med større informasjon kan brukerne forvente at samtalene blir mer sofistikerte.

Sikkerhetstiltak i den nye modellen

I likhet med de eksisterende GPT-modellene er GPT-4o designet med visse sikkerhetstiltak i tankene for å sikre sikkerhet. Treningsdataene er filtrert og hvordan modellen oppfører seg er finpusset etter trening. OpenAI har også evaluert AI-modellen på tvers av flere parametere, som cybersikkerhet og overtalelse, for å unngå uønskede hendelser.

Utover det tok utviklerne hjelp av over 70 eksperter på ulike felt som feilinformasjon og sosialpsykologi for å identifisere og redusere risikoer som kan oppstå eller øke med den nye modellen. De vil også fortsette å overvåke bruken av chatboten for fremtidige risikoer og ta de nødvendige handlingene når og når det er nødvendig.

Til å begynne med vil OpenAI bare gjøre tilgjengelig et begrenset utvalg av forhåndsinnstillinger for stemmemodeller. Den vil også ta hensyn til tilbakemeldinger fra brukeren for å forbedre modellen og sikre full sikkerhet.

GPT-4o Tilgjengelighet

Til nå var det to versjoner av ChatGPT tilgjengelig – en gratisversjon som kjører på GPT 3.5 og en betalt versjon som kjørte på GPT 4.0 og koster $20 per måned. Sistnevnte kan få tilgang til en større språkmodell som lar den håndtere større mengder data.

GPT-4o vil være tilgjengelig for både gratis og betalte brukere og forventes å rulle ut til enheter i løpet av de kommende ukene. Den vil være tilgjengelig på mobile enheter gjennom den eksisterende appen, som vil bli oppdatert, og en ny macOS desktop-app vil også være tilgjengelig i tillegg til nettversjonen for stasjonære brukere (Windows-versjonen kommer senere i år).

For å skille mellom gratis og betalte brukere, vil OpenAI tilby betalte brukere fem ganger mer kapasitet enn det som vil bli tilbudt gratisbrukere. Når du går tom for grensen din, vil du bli byttet tilbake til ChatGPT 3.5.

OpenAIs kunngjøring angående GPT-40 kommer bare én dag før Googles årlige I/O-utviklerkonferanse, hvor Google forventes å komme med sine egne AI-relaterte kunngjøringer. OpenAI har også lovet at flere kunngjøringer er på vei, så det er ingen tvil om at konkurransen mellom de to rivalene så vidt begynner å bli varmere.

Selv om vi ikke vet når OpenAI vil avsløre flere endringer i AI-modellen, vet vi at GPT-4o er på vei til enheter som kjører ChatGPT globalt. Så, kryss fingrene og vent til oppdateringen vises på enheten din. Til neste gang!

Legg att eit svar