Google annonserte nylig en rekke oppdateringer til Gemini AI-modellen, inkludert flere oppgraderinger og nye modeller. Blant disse, en som fikk mye oppmerksomhet, var Gemini Live, en multimodal AI-modell som har video- og stemmefunksjoner.

Siden Bard ble omdøpt til Gemini i februar, har AI-modellen fungert som en erstatning for Google Assistant på Android-enheter. Imidlertid er det ganske begrenset hva det kan gjøre for øyeblikket. Med Gemini Live har Google som mål å endre dette ved å tilby en kraftigere og mer allsidig AI-modell.

Hva er Gemini Live?

For å gi brukerne en forbedret AI-opplevelse og for å ta fatt på OpenAIs GPT-4o forbedrede ChatGPT, annonserte Google Gemini Live på sin I/O-utviklerkonferanse nylig. Gemini Live vil tillate brukere å ha naturlige og personlige samtaler i sanntid med den gjennom stemme, og senere, video.

Den nye AI-modellen er en del av Googles Project Astra, som er søkegigantens forsøk på å bygge en universell AI-assistent som kan bruke ulike typer input fra hverdagen for å gi assistanse. For eksempel kan Gemini Live bruke tekst, bilder fra smarttelefonkameraet og stemmen din for å svare på spørsmål.

Ifølge Google vil den nye naturlige språkmodellen ikke bare hjelpe brukere med å løse problemer og utføre ulike handlinger, men også føle seg helt naturlig under interaksjoner. Brukere vil kunne starte Gemini Live ved å trykke på stemmeikonet på telefonen, som vil vise AI i fullskjerm med en lydbølgeformeffekt.

Du kan da snakke med AI akkurat som du ville gjort med en ekte personlig assistent. Et utmerket eksempel på hvordan den oppgraderte AI-modellen kan hjelpe deg er når du ber den om å hjelpe deg med et intervjuforberedelse. Gemini Live vil foreslå ferdighetene du kan fremheve, gi offentlige talertips og mer.

Egenskaper

Gemini Live kommer med noen få funksjoner som gjør den til en mye bedre AI-assistent enn Google Assistant, Apples Siri eller Amazons Alexa.

Toveis stemmesamtaler

Gemini Live lar deg snakke med det og gir menneskelignende verbale svar, noe som resulterer i engasjerende og intuitive samtaler. Du kan for eksempel spørre den om været, og det vil gi deg en nøyaktig og kortfattet oppdatering.

Smart Assistant-funksjoner

AI-modellen kan fungere som en smart assistent og utføre oppgaver som å oppsummere informasjon fra e-poster og oppdatere kalenderen din. Du kan for eksempel ta et bilde av en konsertflyer, og Gemini legger til hendelsen i kalenderen din.

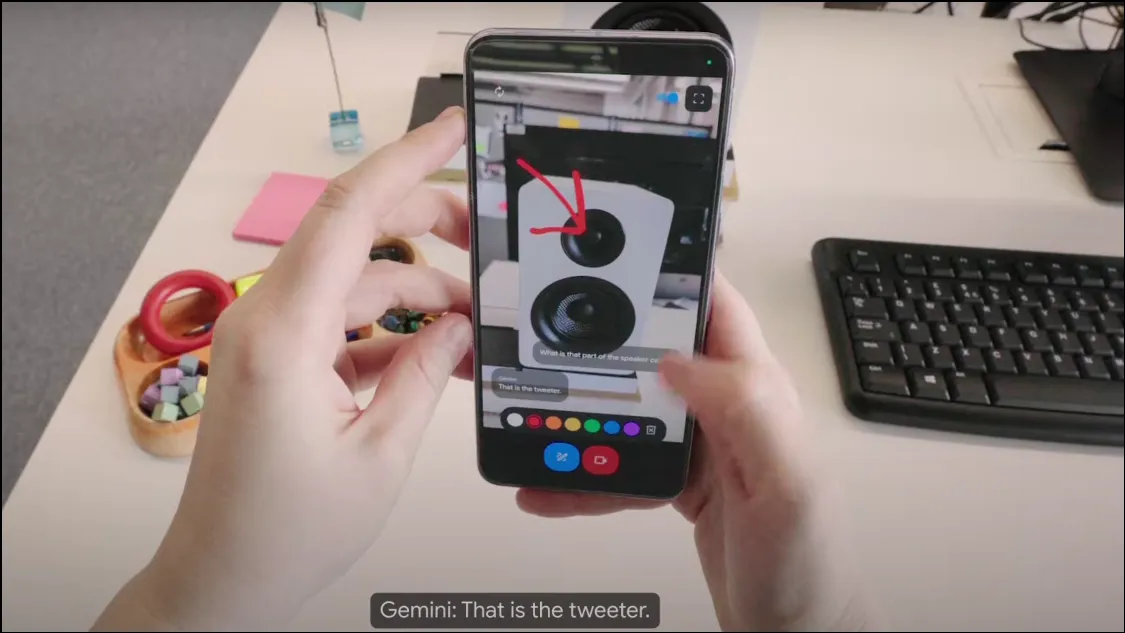

Visuelle evner

Ved å bruke kameraet på smarttelefonen din kan Gemini Live ta opp videoer i sanntid. Dette lar den identifisere objekter og svare på spørsmål angående dem. For eksempel, hvis du retter smarttelefonkameraet mot en høyttaler og ber Gemini om å identifisere det, vil det fortelle deg hva det er og til og med identifisere merke og modell.

Hvordan fungerer Gemini Live?

Project Astra kan kombinere tale og visuelle innganger som gjør dem enkle å forstå for AI-modellen. Den kan deretter reagere på informasjonen og gi nødvendig hjelp. I likhet med OpenAIs GPT-4o-drevne ChatGPT, er Gemini Live en multimodal AI og er ikke bare avhengig av tekst som input.

Mens Gemini Live opprinnelig vil bruke stemmeinndata for å samle inn og analysere data ved den første utgivelsen, vil den bli oppgradert i løpet av de kommende månedene til også å behandle og analysere videoer ved å bryte dem ned ramme for ramme for bedre forståelse og interaksjon.

AI kan tilpasse seg hastigheten forskjellige brukere snakker med, og du kan til og med avbryte den for å be om avklaring eller gi mer informasjon. Dens evne til å etterligne menneskelig dialog kan gi en mer engasjerende interaksjon. Dermed kan du ha en frem og tilbake samtale med den, akkurat som med en menneskelig assistent. I tillegg vil du kunne velge mellom ti forskjellige stemmer for AI.

GPT-4o vs. Gemini Live

Mens både GPT-4o og Gemini Live er multimodale AI-modeller, er det akkurat nå vanskelig å se hvilken som presterer best i det virkelige liv, spesielt siden ingen av dem er offentlig tilgjengelig for øyeblikket.

Imidlertid, i motsetning til ChatGPT, er Gemini Live avhengig av andre AI-modeller som Google Veo og Imagen 3, for å gi utdata i form av videoer og bilder. Til tross for det, i demoene som ble vist frem av OpenAI og Google, virket ChatGPT mer naturlig, og den nye GPT-4o-modellen kunne til og med oppdage og simulere menneskelige følelser gjennom vokaltoner.

I tillegg kan den tilpasse seg måten du vil at den skal svare på, noe Gemini Live ikke kan gjøre, i det minste i den nåværende tilstanden.

Gemini Live Tilgjengelighet

Gemini Live vil være tilgjengelig for Gemini Advanced-abonnenter, som er den betalte versjonen av AI-chatboten. Det vil bli rullet ut i løpet av de kommende månedene og forventes å være allment tilgjengelig innen slutten av året.

Apper som Google Messages vil kunne dra full nytte av Gemini Live, slik at brukere kan samhandle med AI direkte i meldingsappen.

Gemini Live kan være den neste store oppgraderingen til Googles AI-chatbot, og akkurat det den trenger for å møte rivaler som OpenAIs ChatGPT. Med multimodal funksjonalitet og kraftige talefunksjoner kan den oppgraderte modellen hjelpe Google med å lykkes med å levere en allsidig og pålitelig digital assistent.

Akkurat nå har Google bare annonsert at de vil bringe den nye AI-modellen til betalte abonnenter. Selv om dette utelater gratis brukere, som utgjør en stor del av Googles brukerbase, håper vi Google endrer holdning og bestemmer seg for å utvide tilgjengeligheten til Gemini Live.

Legg att eit svar