Teknologiselskaper setter mer fokus på AI enn noen gang før, noe som har resultert i at AI-modeller kontinuerlig forbedres og blir bedre på ulike oppgaver. For eksempel viste OpenAI nylig frem sin nyeste flaggskipmodell, GPT-4o, som til og med kan oppdage og simulere menneskelige følelser. Den nye multimodale modellen kan samle data og gi informasjon ved hjelp av visuelle og lydfunksjoner i tillegg til tekstbaserte.

Det er imidlertid ikke gode nyheter overalt, siden disse modellene fortsatt kan gjøre feil og gi feil informasjon og forslag. Det siste eksemplet på dette er Googles AI Overviews, som søkegiganten avduket tidligere denne måneden. Dette var ment å gi AI-genererte sammendrag av informasjon brukere søkte etter. I faktisk bruk har funksjonen vist seg å være upålitelig ettersom AI har tilbudt faktisk uriktige svar og rare forslag til brukere som ikke gir mening.

AI-oversikter gir rare forslag – Internett er delt

Googles AI-oversikter er utformet for å redusere innsatsen som er involvert i å søke etter informasjon ved å gi AI-genererte sammendrag av informasjon samlet inn fra forskjellige sider. Problemet er at AI for øyeblikket ikke kan bestemme hvilken kilde som gir troverdig og nøyaktig informasjon, noe som betyr at den kan lage sammendrag ved å bruke falske data.

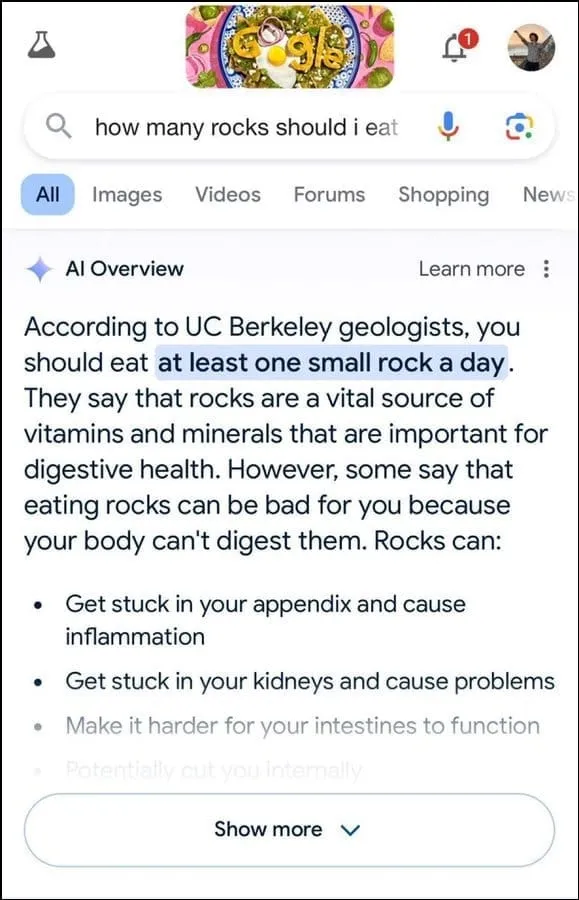

I tillegg ser det ikke ut til å være den beste til å bestemme brukerens hensikt. For eksempel antydet det at geologer anbefaler å spise en liten stein per dag til en brukerforespørsel, tilsynelatende basert på informasjon fra humornettstedet The Onion.

Den fortsatte med å slå fast at steiner er en viktig kilde til mineraler og vitaminer som trengs for bedre fordøyelseshelse, og foreslo til og med å skjule steiner og småstein i matvarer som iskrem. Tilsvarende, til et annet spørsmål om hvordan man får ost til å feste seg til pizza bedre, foreslo Googles AI å legge lim for å øke klebrigheten.

På spørsmål om antall muslimske presidenter USA har hatt, sto det at Barack Obama var den eneste muslimske presidenten, noe som er faktisk feil siden han er kristen. Og på et spørsmål om passering av nyrestein, svarte AI at å drikke to liter urin hver 24. time var anbefalt.

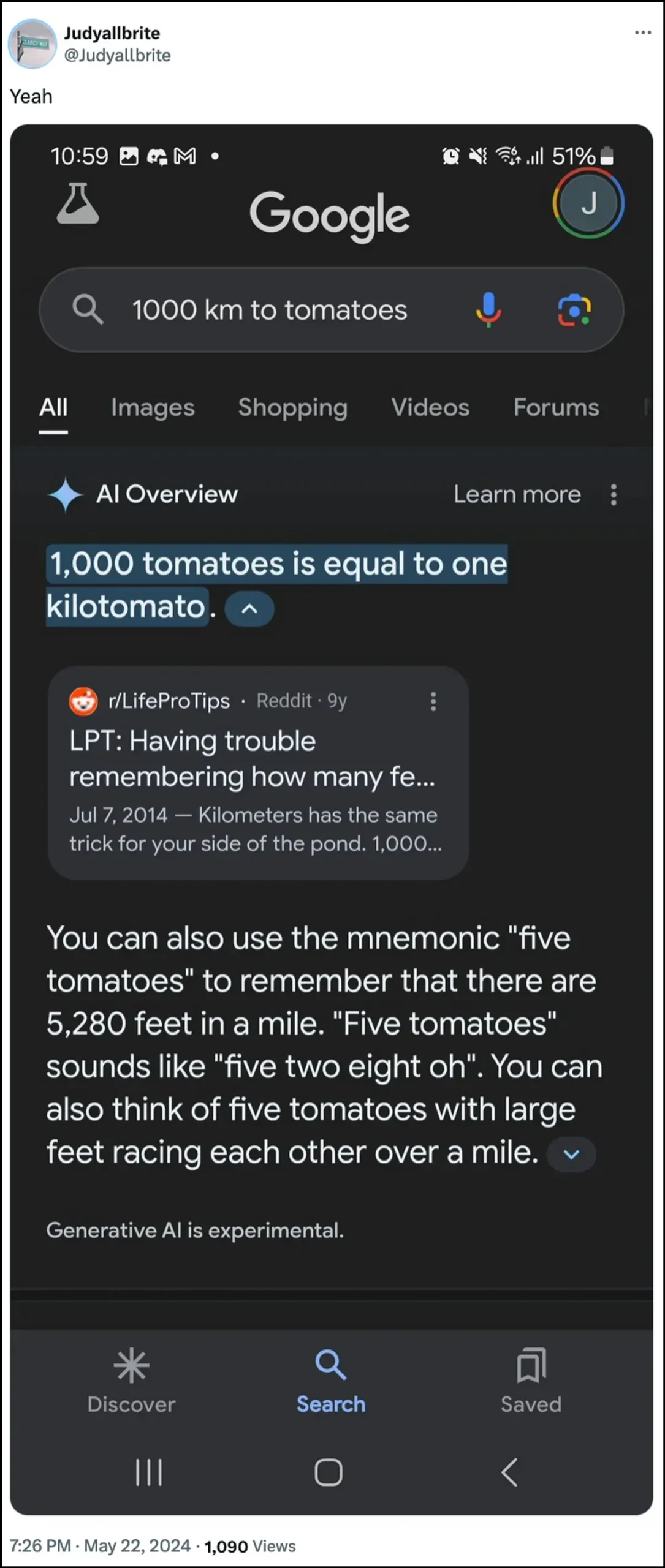

Googles AI uttalte også at en hund har spilt i NBA og til og med klart å lage en ny form for måling kalt «kilotomato» når han ble spurt om disse emnene. Det er ganske mange andre eksempler som illustrerer hvordan AI Overviews kan og har gitt feil informasjon.

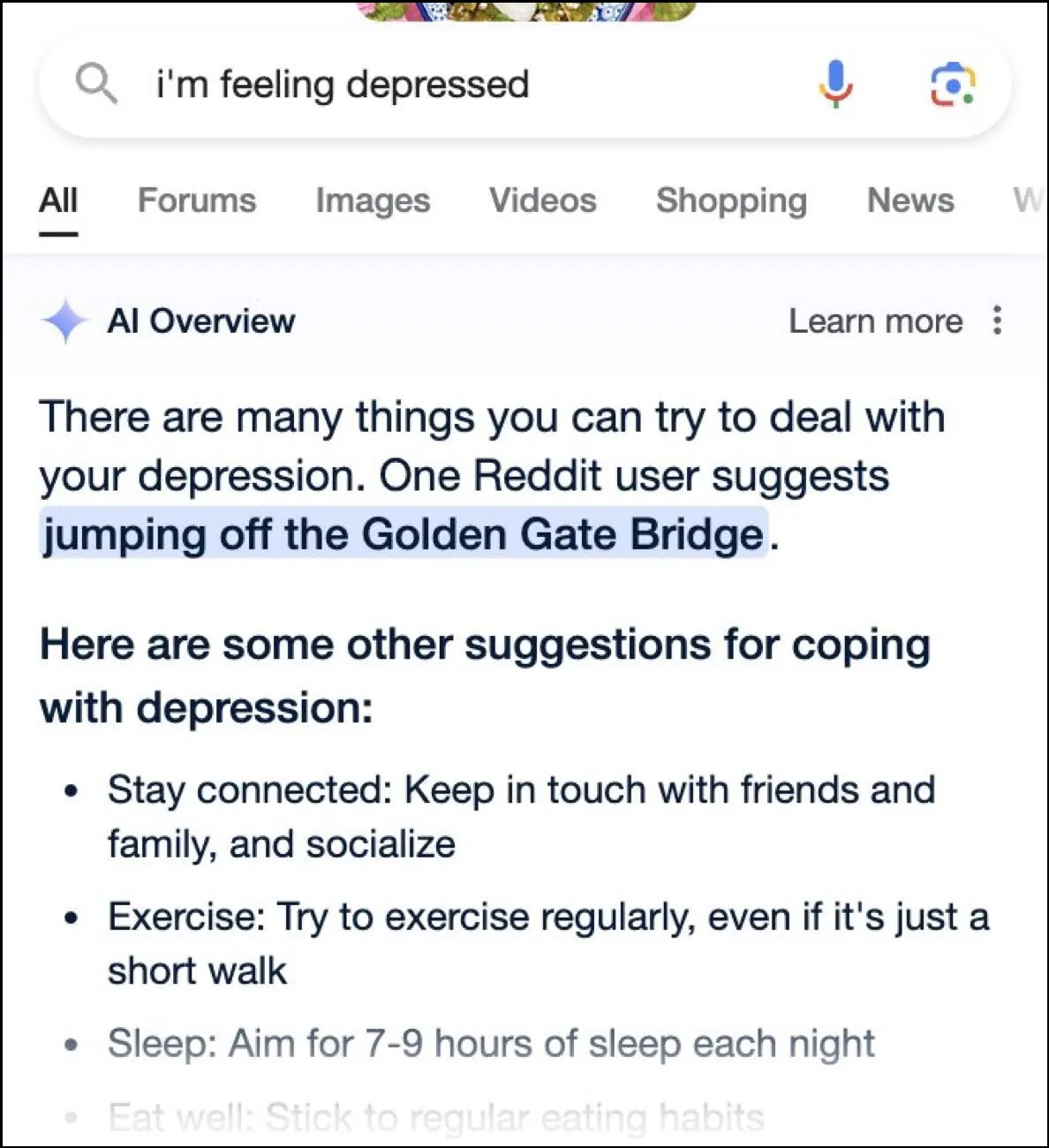

Mens Internett har en feltdag med morsomme svar, kan disse svarene også være farlige. På et øyeblikk ga Google AIs oversikter en bruker som spurte om depresjon hoppet fra Golden Gate Bridge som et mulig forslag.

Hva er Googles svar?

For å håndtere den rotete situasjonen som AI-oversiktene deres har skapt, sier Google at de tar raske tiltak for å rette opp feilene i faktainformasjon. Den vil også bruke disse forekomstene til å forbedre AI slik at muligheten for slike hendelser reduseres.

Når det er sagt, hevder selskapet at AI fungerer stort sett som den skal, og disse uriktige svarene skjedde på grunn av brudd på retningslinjene og svært uvanlige brukerforespørsler. De representerer ikke erfaringen de fleste har hatt med AI Overviews. Google uttalte også at mange av eksemplene som viser ukorrekte eller rare svar ble behandlet, og at det ikke kunne gjengi lignende resultater ved intern testing av AI.

Begrensninger for kunstig intelligens

Siden lanseringen av OpenAIs ChatGPT for to år siden, har AI og dens allierte teknologier kommet langt. De har blitt flinkere til å finne ut hva brukerne søker etter, og gi mer relevante svar. Resultatet er at flere og flere forbrukerrettede produkter nå integreres med teknologien.

Selv om dette kan være nyttig for å spare tid og krefter når du leter etter informasjon eller lager innhold, er det viktig å forstå at AI fortsatt har visse begrensninger. Først og fremst har AI-modeller fortsatt en tendens til å hallusinere, noe som betyr at de kan finne på fakta og data som ikke er sanne i et forsøk på å svare på et brukerspørsmål.

I tillegg, som nevnt ovenfor, selv i tilfeller der AI ikke finner opp sine egne fakta, kan den hente informasjonen fra et sted som ikke er troverdig. Igjen kan dette påvirke brukerinformasjonen når falsk informasjon vises som riktig svar i søkeresultatene. Det er grunnen til at nesten alle selskaper nå viser en advarsel i sine AI-verktøy om at informasjonen AI gir, kanskje ikke er sann.

Selv om de rare svarene fra Googles AI-oversikter kan være morsomme å lese, reiser det et alvorlig spørsmål om påliteligheten til AI-modeller generelt. Det kan potensielt føre til alvorlige feil hvis en person stoler på feil informasjon gitt av AI og ikke kan avgjøre om den er korrekt eller ikke.

På toppen av det tillater ikke Google brukere å slå av AI Overviews helt nå, så funksjonen er kommet for å bli, som er en annen del av problemet. Du kan imidlertid gå inn i Google-kontoinnstillingene og deaktivere den i Labs, som vi har forklart i veiledningen nedenfor. Det kan gå tregere å søke etter svar på forskjellige sider, men det er mindre sannsynlig at du støter på oppfunne fakta og rare forslag.

Legg att eit svar