Mens mange nettlesere integrerer AI-funksjoner i nettleserne sine, ble Opera nettopp den første nettleseren som integrerte lokale AI-modeller. Opera legger til eksperimentell støtte for over 150 Local Large Language Model-varianter (LLM) fra rundt 50 forskjellige familier av modeller til Opera One-nettleseren deres.

Siden språkmodellene vil være lokale, trenger ikke brukere å bekymre seg for at dataene deres sendes til LLMs server. Det er en privat og sikker måte å bruke AI på.

For å bruke de lokale LLM-modellene trenger du 2-10 GB plass på datamaskinen, avhengig av varianten du skal bruke. Noen av de støttede LLM-ene inkluderer Llama fra Meta, Phi-2 fra Microsoft, Gemma fra Google, Vicuna, Mixtral fra Mistral AI osv. Du kan bruke disse språkmodellene i stedet for Aria AI fra Opera og bytte tilbake til Aria AI når du ønsker.

Funksjonen er foreløpig bare tilgjengelig i utviklerstrømmen til Opera One. Slik kan du aktivere og bruke de lokale AI-modellene i Opera One Developer.

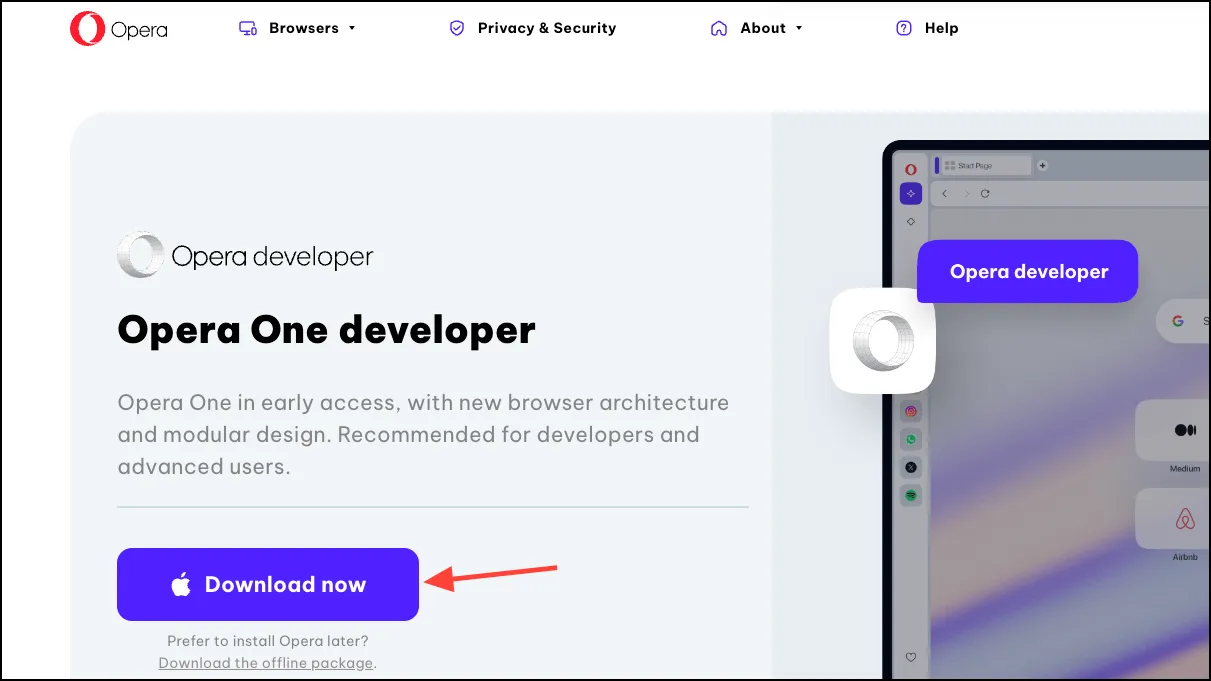

Last ned Opera One Developer

Hvis du allerede har Opera One Developer, hopper du over denne delen og går rett frem til å bruke de lokale LLM-modellene.

- Gå til denne lenken for å laste ned Opera One Developer. Rull ned og klikk «Last ned nå» på Opera One Developer-flisen.

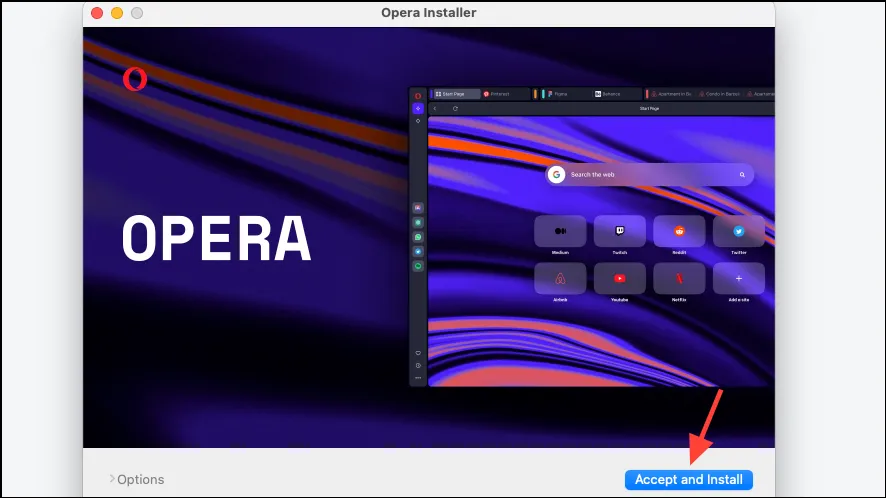

- Åpne filen når den er lastet ned og kjør installasjonsprogrammet.

- Klikk på «Godta og installer» og følg deretter instruksjonene på skjermen for å installere nettleseren.

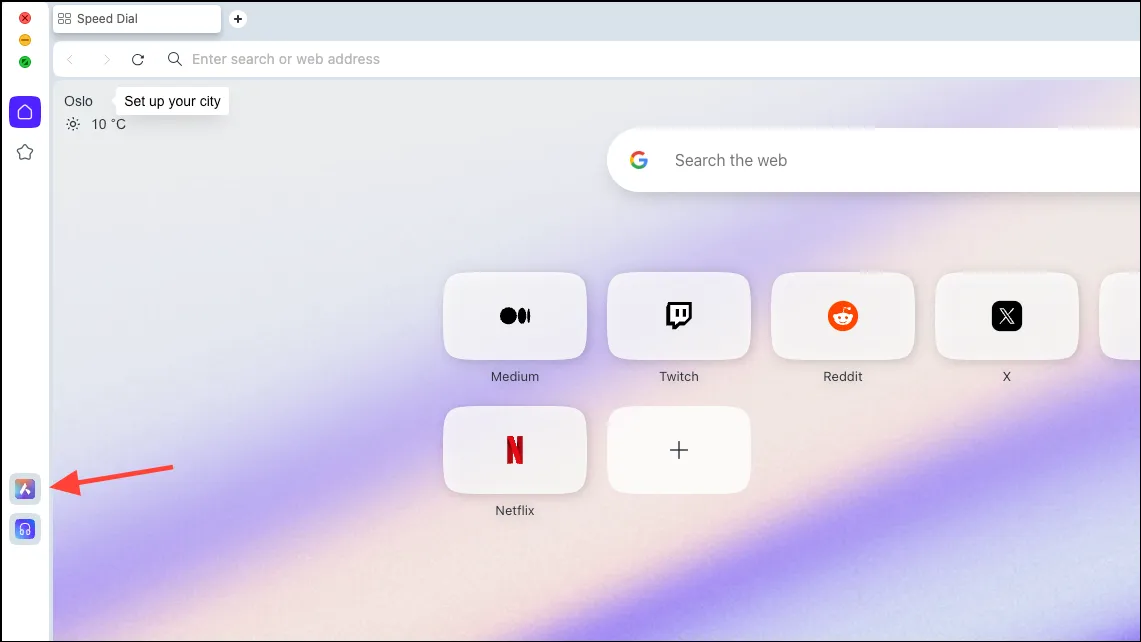

Sett opp lokal AI-modell

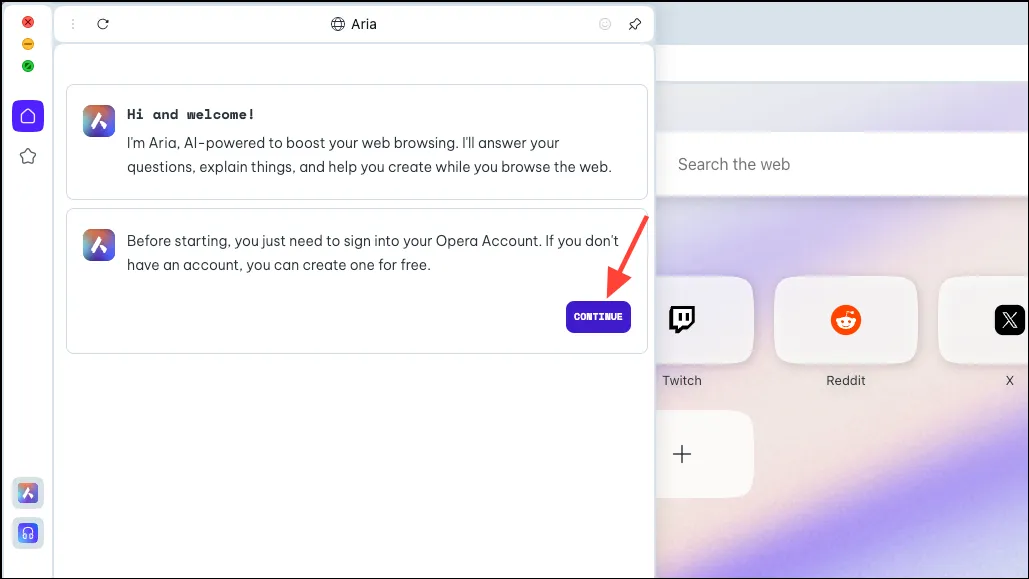

- Når nettleseren er lastet ned, klikk på «Aria AI»-ikonet fra venstre sidefelt.

- Klikk på «Fortsett» for å fortsette.

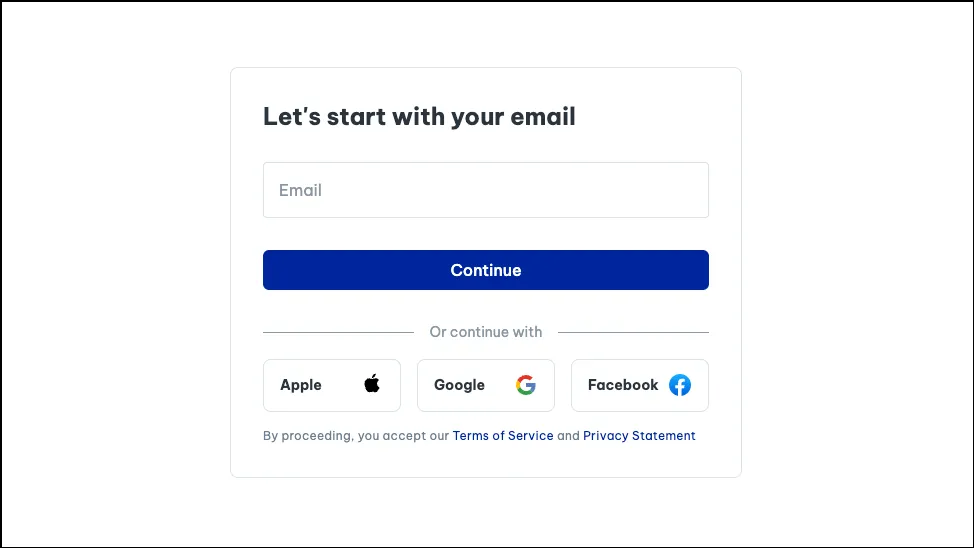

- Hvis du bruker Aria for første gang, må du registrere deg for en gratis Opera-konto for å bruke den. Du kan bruke e-posten din eller Apple-, Facebook- eller Google-kontoen din til å opprette en Opera-konto.

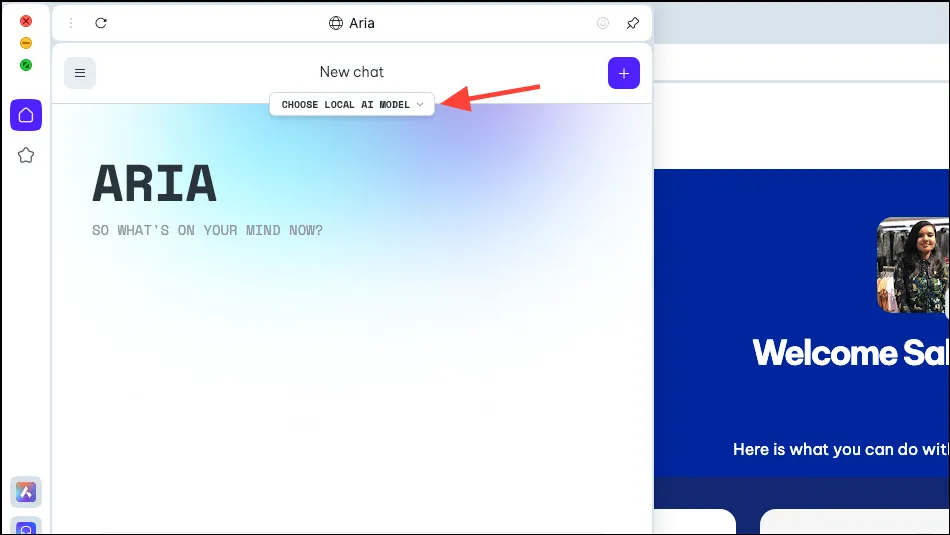

- Når kontoen din er opprettet, vil du kunne chatte med Aria.

- Nå, i Aria-panelet, vil du se et alternativ, «Velg lokal AI-modell». Klikk på den.

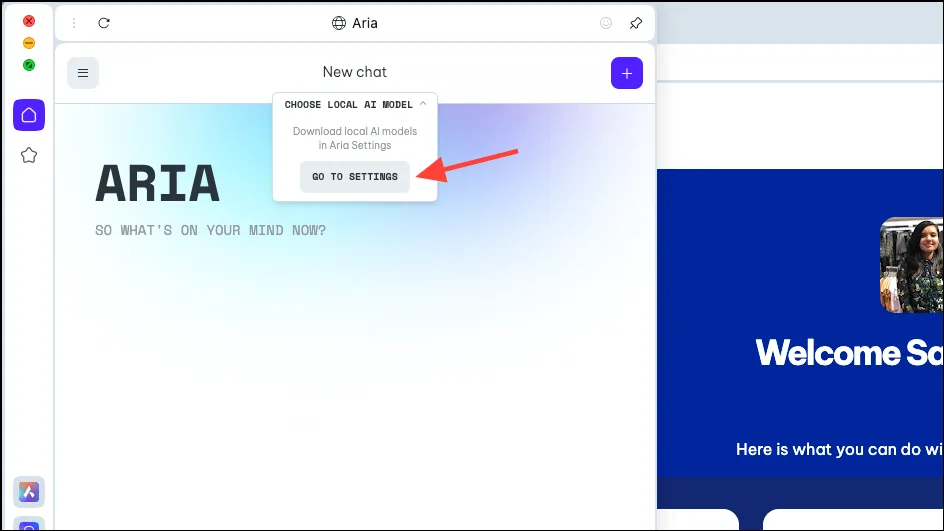

- Velg «Gå til innstillinger» fra rullegardinmenyen.

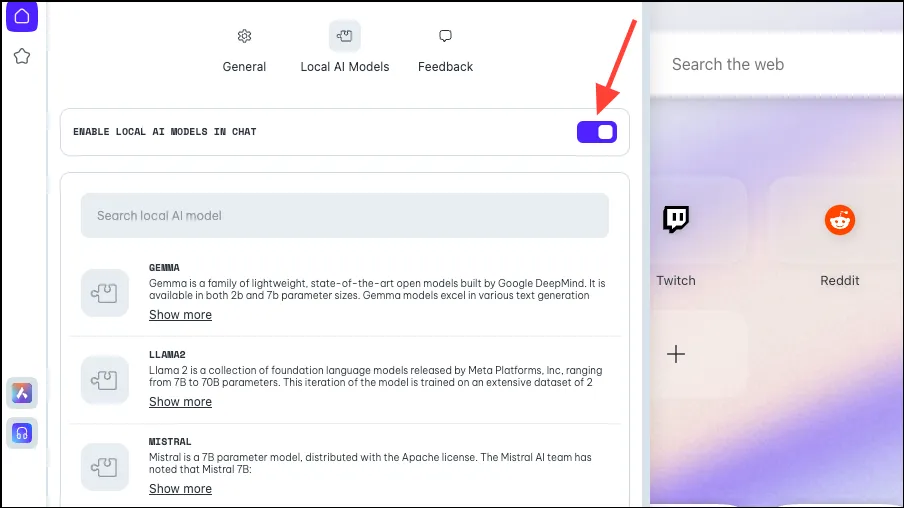

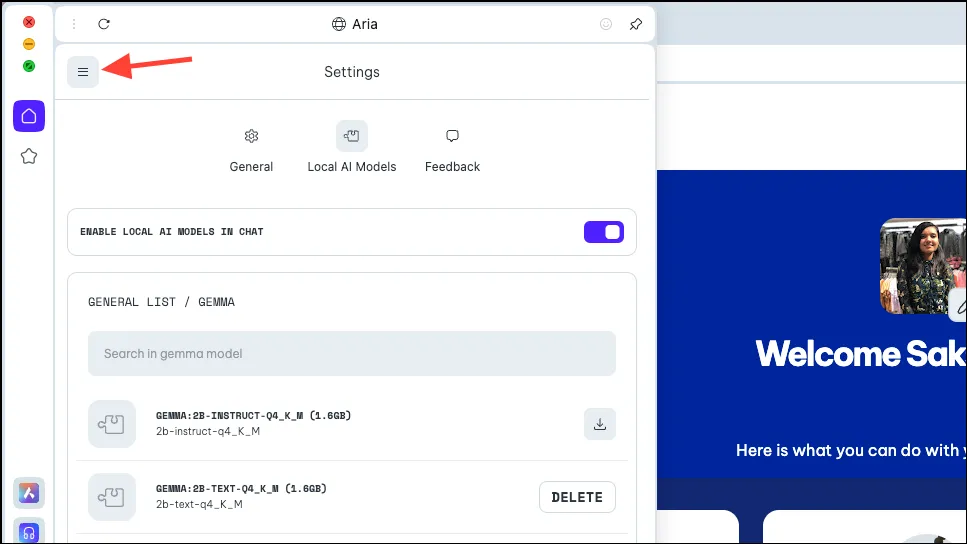

- Sørg for at bryteren for «Aktiver lokal AI i chatter» er aktivert.

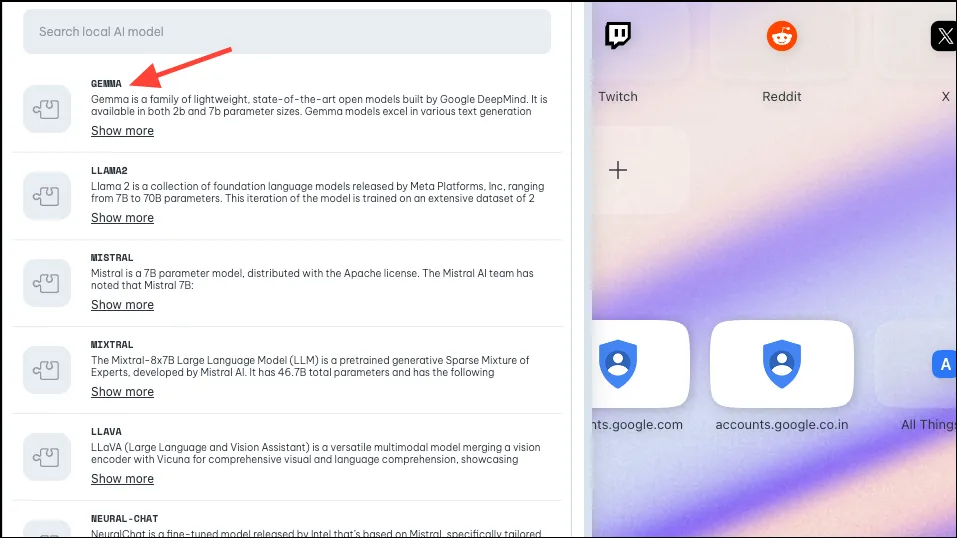

- Deretter velger du modellen du vil laste ned for lokal bruk, enten ved å klikke eller søke etter den. Som nevnt ovenfor har Opera implementert støtte for omtrent 50 modellfamilier med forskjellige varianter, noe som bringer totalen til 150.

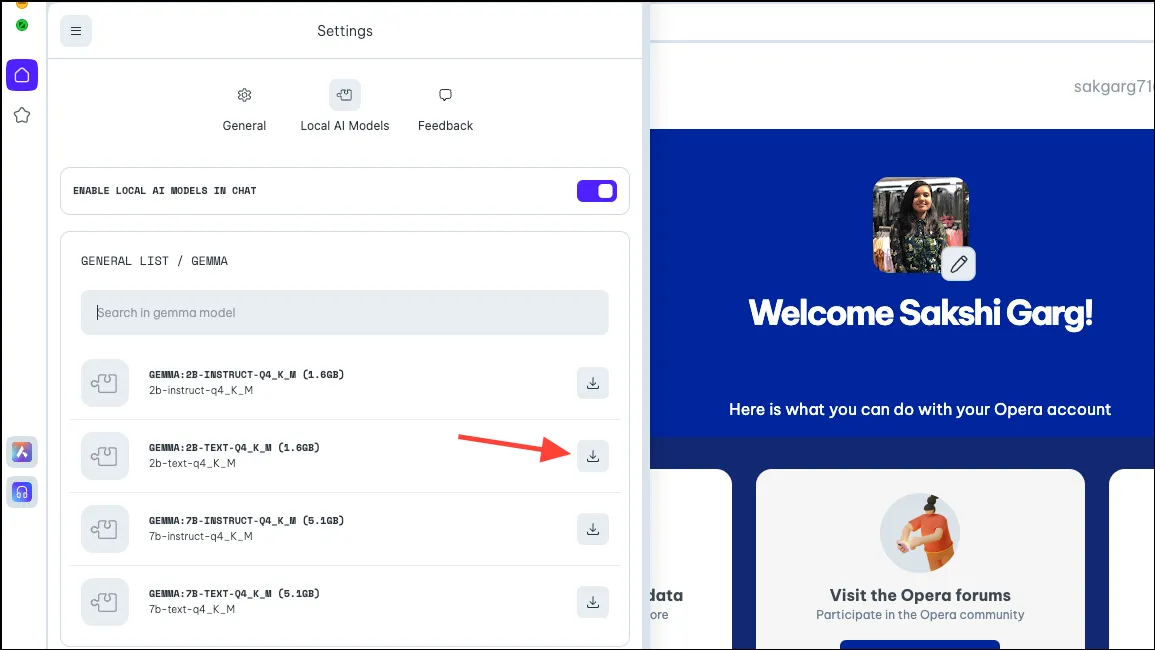

- Så, for noen modeller, når du klikker på noen av modellene, som Googles Gemma, får du 4 forskjellige varianter. Last ned modellen du vil bruke. For denne guiden laster vi ned Gemmas 2B Text-modell. Klikk på «Last ned»-knappen til høyre. Du kan se hvor mye plass modellen krever på PC-en din før du laster den ned.

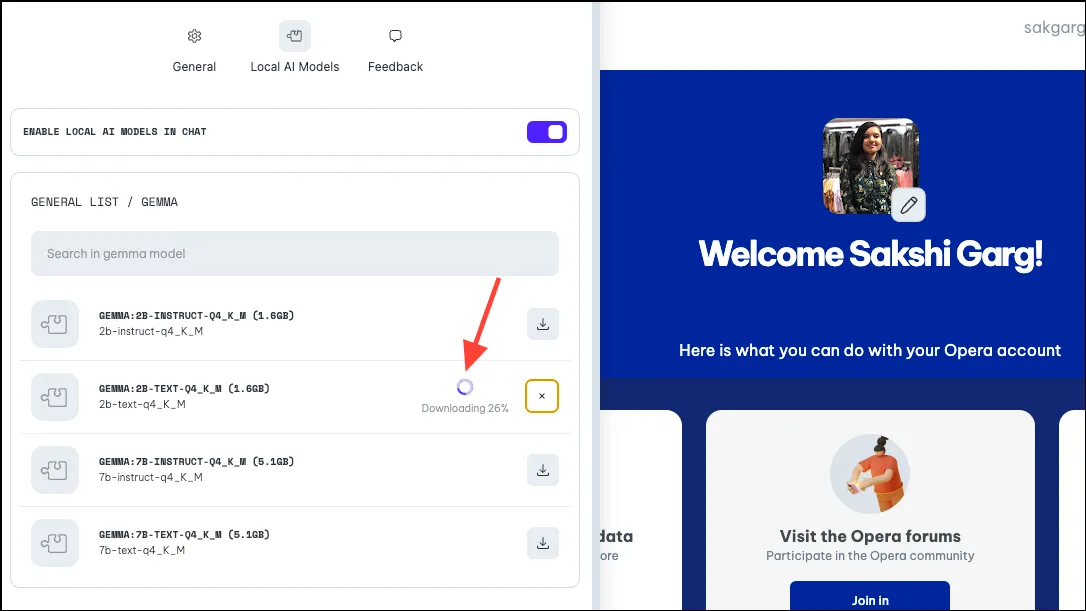

- Nedlastingen vil ta litt tid, avhengig av modellstørrelsen og internettforbindelsen din. Du kan se fremdriften for nedlastingen ved siden av.

Bruker den lokale AI-modellen

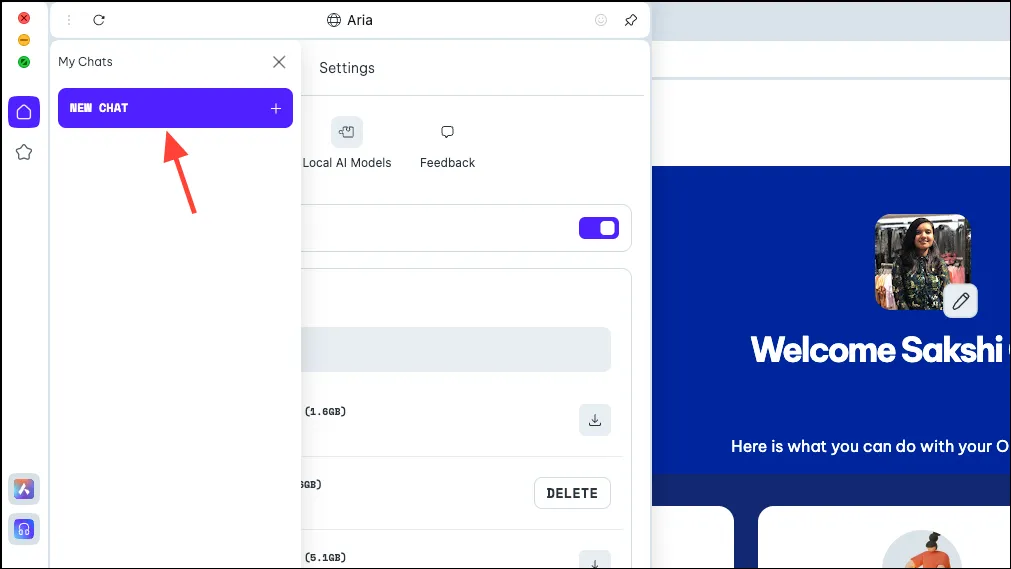

- Når modellen er lastet ned, klikker du på «Meny»-ikonet øverst til venstre i panelet.

- Velg «Ny chat» fra menyen som vises.

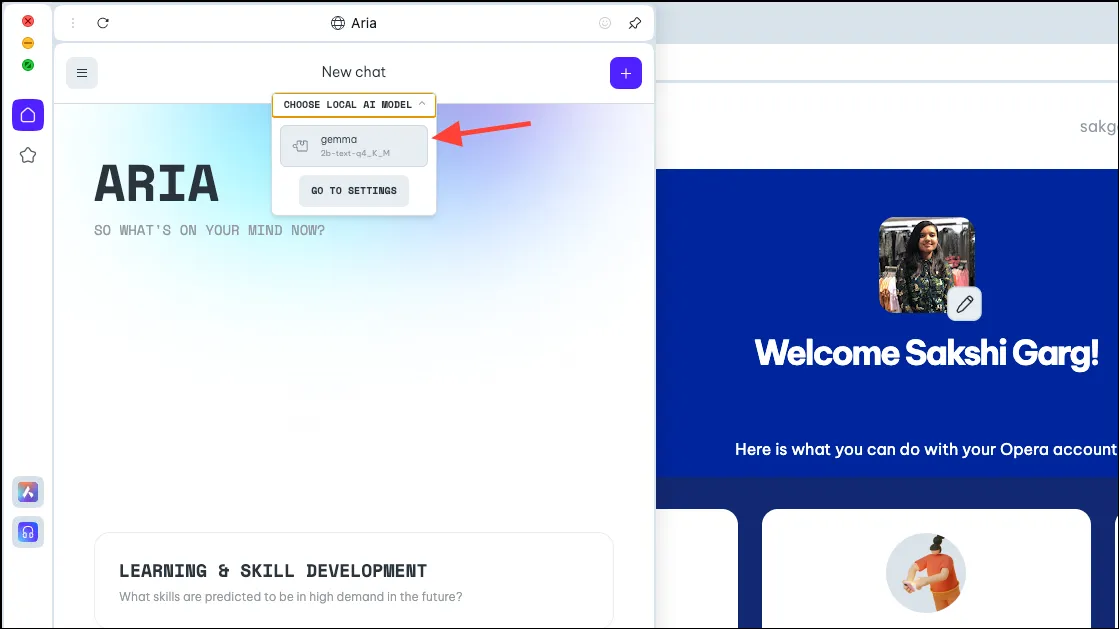

- Igjen, klikk på «Velg lokal AI-modell»-alternativet øverst og velg modellen du nettopp lastet ned, Gemma i vårt tilfelle, fra rullegardinmenyen.

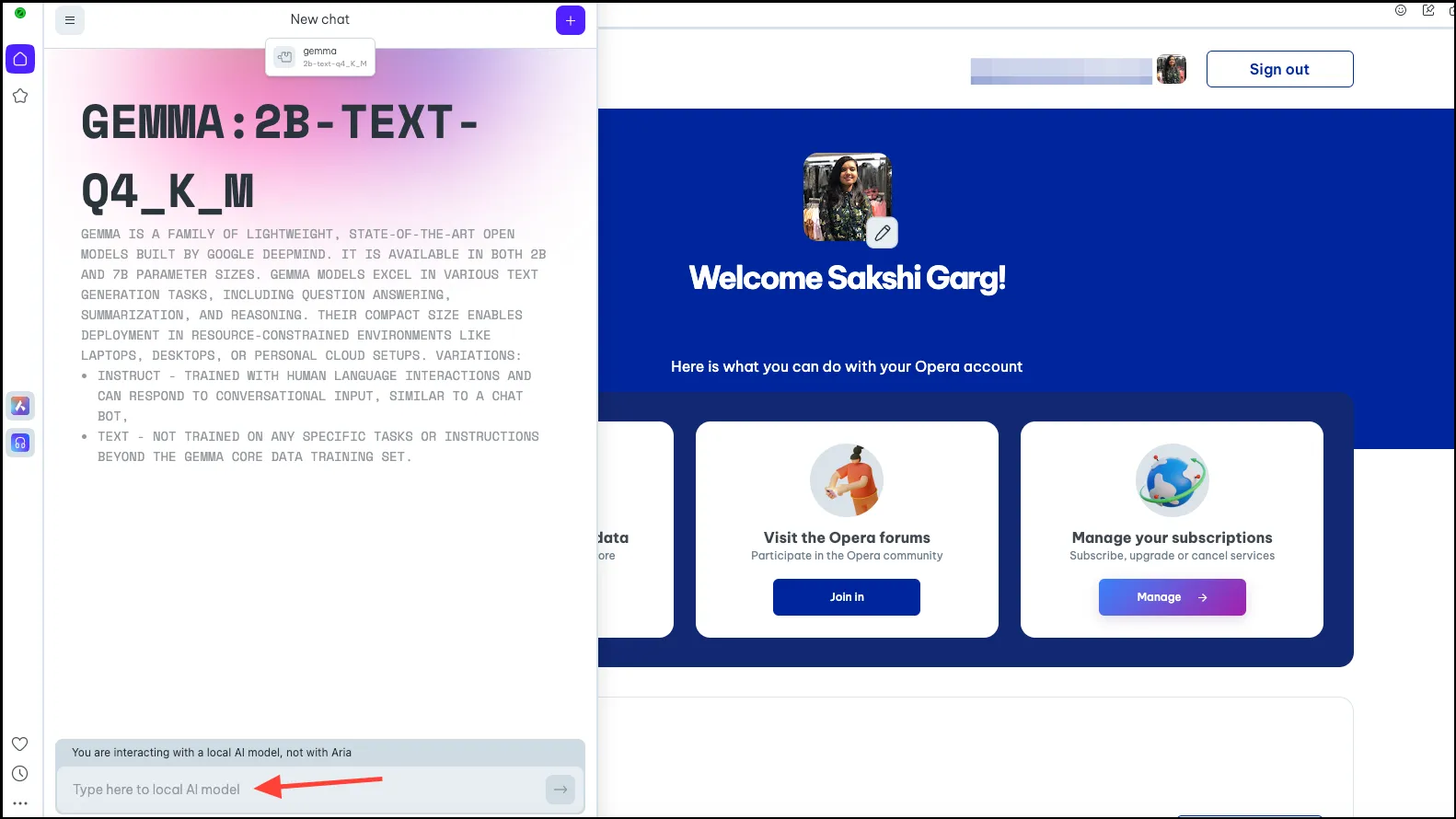

- Du vil nå bli byttet til den lokale AI-modellen du velger. Skriv inn ledeteksten i ledetekstlinjen og send den til AI for å starte lokale interaksjoner.

- Chattene dine med den lokale AI-modellen vil være tilgjengelig i chatteloggen, akkurat som chattene dine med Aria er. Du kan også gi nytt navn til chattene for bedre organisering.

- På samme måte kan du laste ned og bruke flere lokale AI-modeller, men husk at hver av dem krever et sted mellom 2-10 GB plass på datamaskinen din.

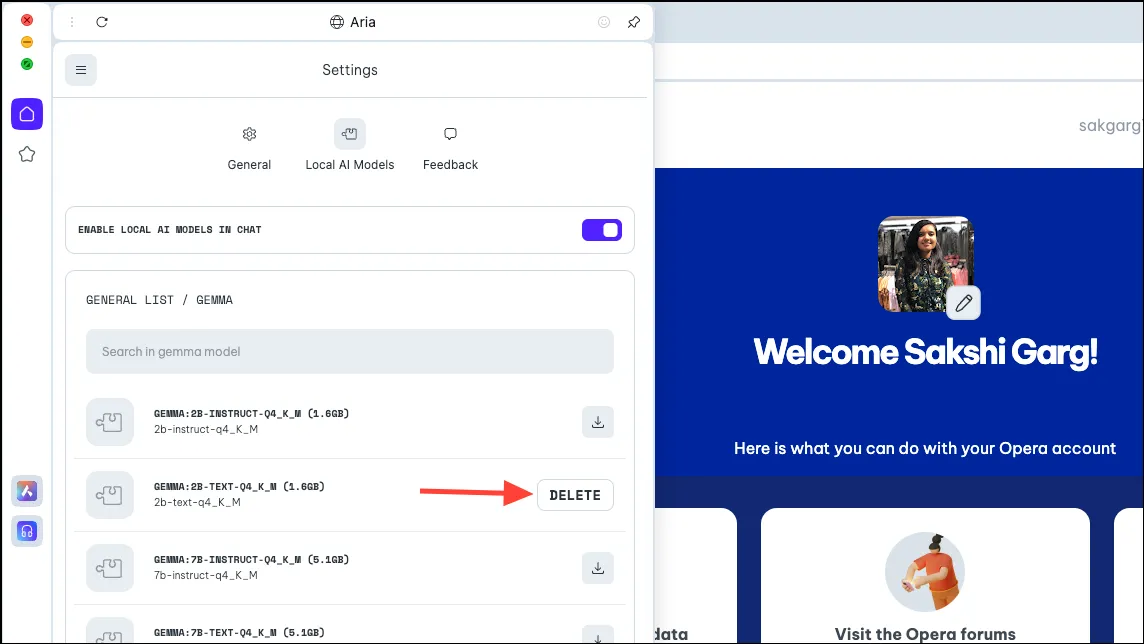

- For å slette modellen fra PC-en din, naviger til de samme innstillingene der vi lastet ned modellen tidligere, dvs.

Aria>Settings>Local AI Models>[Downloaded Model]. Klikk deretter på «Slett»-knappen.

Bytt tilbake til Aria

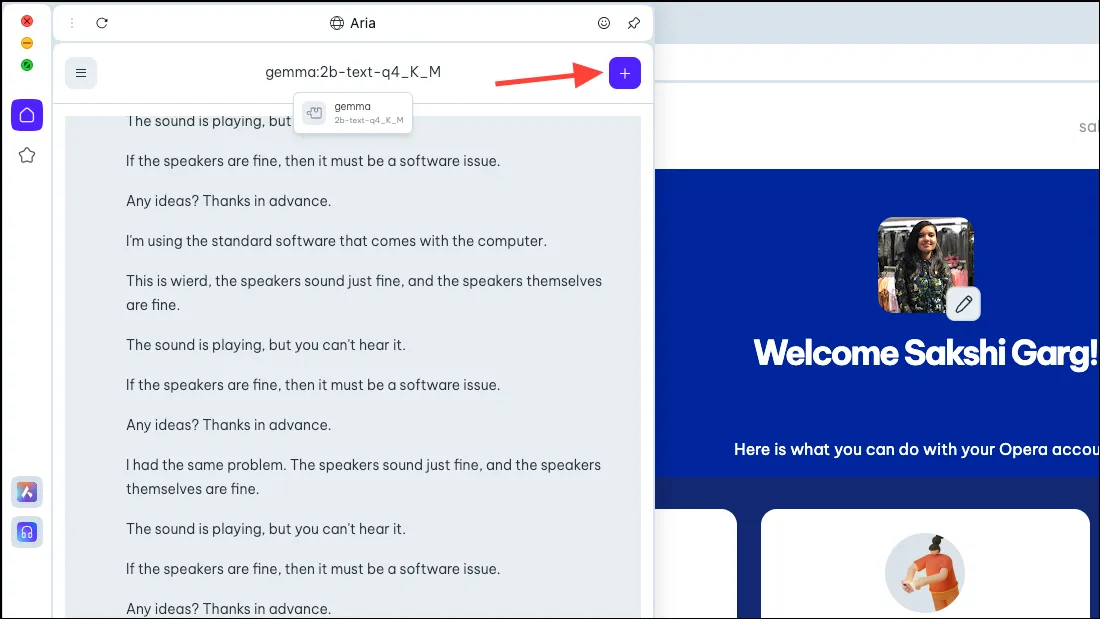

- For å bytte tilbake til Aria, start ganske enkelt en ny chat med AI. Klikk på «+»-ikonet øverst til høyre.

- Den nye chatten starter med selve Aria.

Det er veldig spennende å kunne bruke lokale AI-modeller på Opera One-nettleseren, og ikke bare fra sikkerhets- og personvernstandpunkt. Mens alt i de tidlige stadiene er veldig enkelt, er de potensielle fremtidige sakene ganske spennende. En nettleser med en lokal AI kan bety at den kan bruke dine historiske inndata med alle dataene dine; så spennende ville det vært! Og teamet ved Opera utforsker den muligheten.

Men selv uten fremtidige muligheter, er lokale AI-er et flott trekk for brukere som bekymrer seg for dataene deres og chatter med AI-en som lagres på serverne. Det er noen flotte LLM-er du kan utforske, som Llama for koding, Phi-2 for fremragende resonneringsevner, og Mixtral for oppgaver som tekstgenerering, spørsmålssvar osv.

Legg att eit svar