Hvis du vil kjøre store språkmodeller eller LLM-er på datamaskinen din, er en av de enkleste måtene å gjøre det på gjennom Ollama. Ollama er en kraftig åpen kildekode-plattform som tilbyr en tilpassbar og lett tilgjengelig AI-opplevelse. Det gjør det enkelt å laste ned, installere og samhandle med ulike LLM-er, uten å måtte stole på skybaserte plattformer eller kreve teknisk ekspertise.

I tillegg til fordelene ovenfor, er Ollama ganske lett og oppdateres jevnlig, noe som gjør den ganske egnet for å bygge og administrere LLM-er på lokale maskiner. Dermed trenger du ingen eksterne servere eller kompliserte konfigurasjoner. Ollama støtter også flere operativsystemer, inkludert Windows, Linux og macOS, samt ulike Docker-miljøer.

Laste ned og installere Ollama

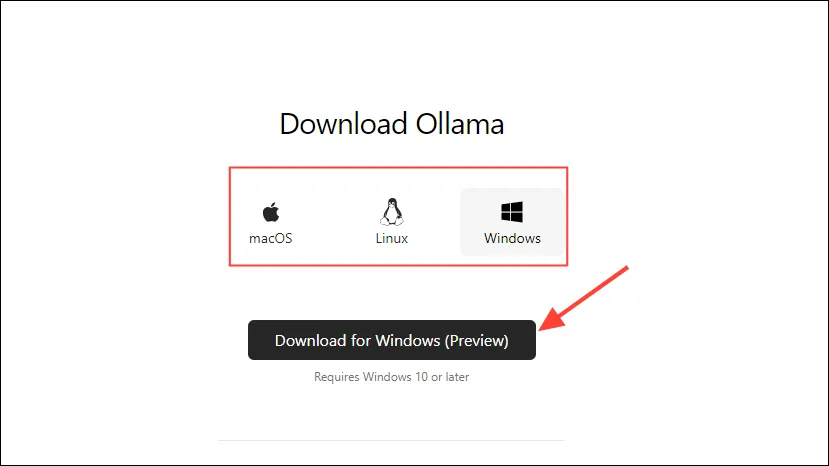

- Gå først til Ollama-nedlastingssiden og velg operativsystemet ditt før du klikker på «Last ned»-knappen.

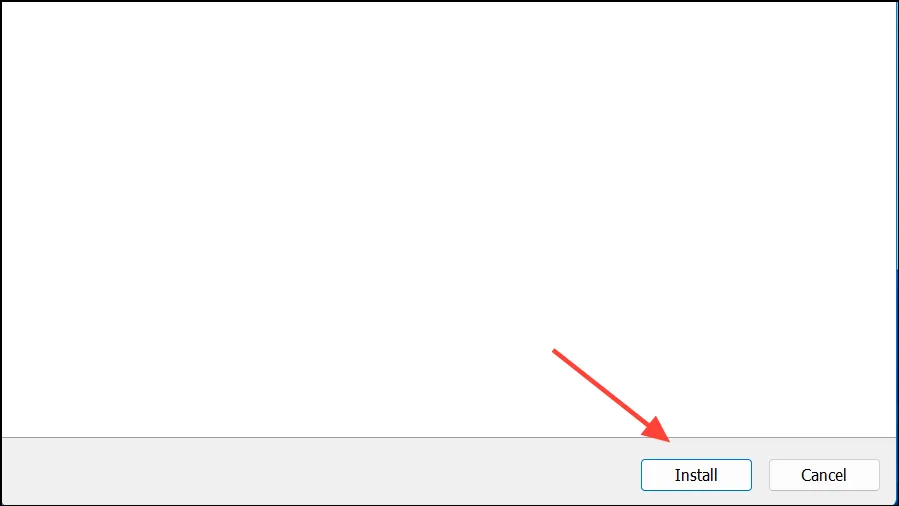

- Når nedlastingen er fullført, åpner du den og installerer den på maskinen din. Installasjonsprogrammet lukkes automatisk etter at installasjonen er fullført.

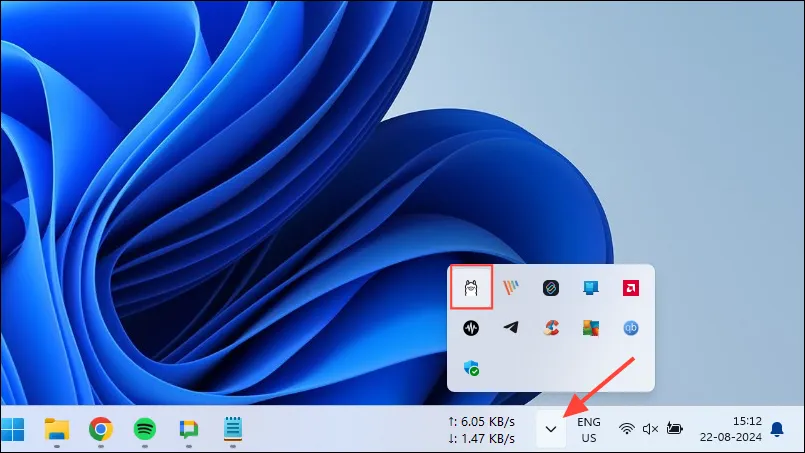

- På Windows kan du sjekke om Ollama kjører eller ikke ved å klikke på overflyt-knappen på oppgavelinjen for å se skjulte ikoner.

Tilpassing og bruk av Ollama

Når Ollama er installert på datamaskinen din, er det første du bør gjøre å endre hvor den lagrer dataene sine. Som standard er lagringsplassen, C:\Users\%username%\.ollama\modelsmen siden AI-modeller kan være ganske store, kan C-stasjonen fylles opp raskt. For å gjøre det,

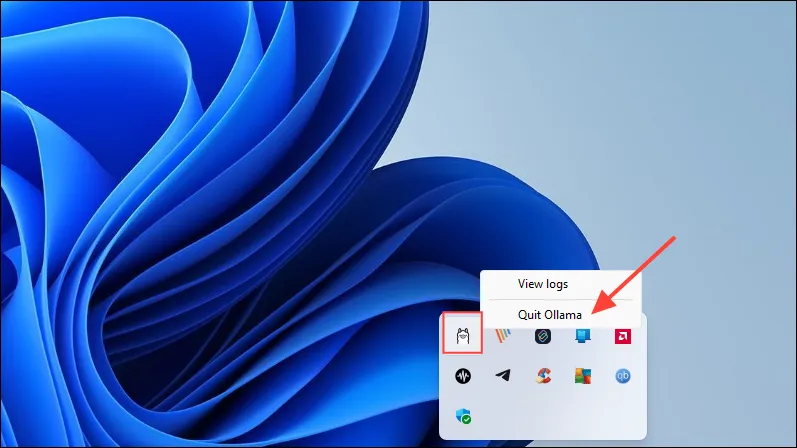

- Først klikker du på Ollama-ikonet på oppgavelinjen og klikker på «Avslutt Ollama».

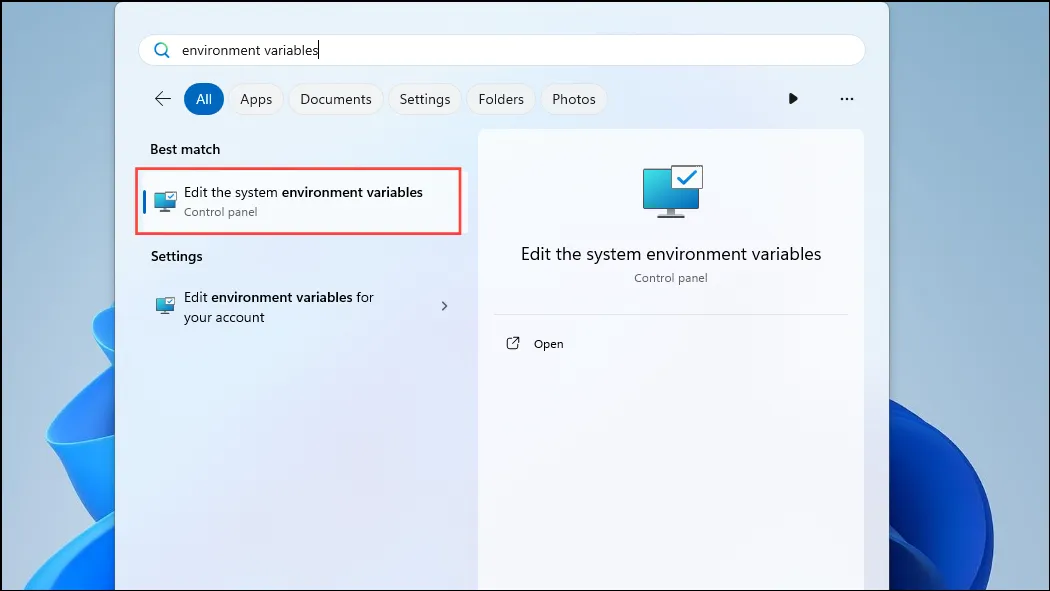

- Når Ollama har avsluttet, åpner du Start-menyen, skriver inn

environment variablesog klikker på «Rediger systemmiljøvariablene».

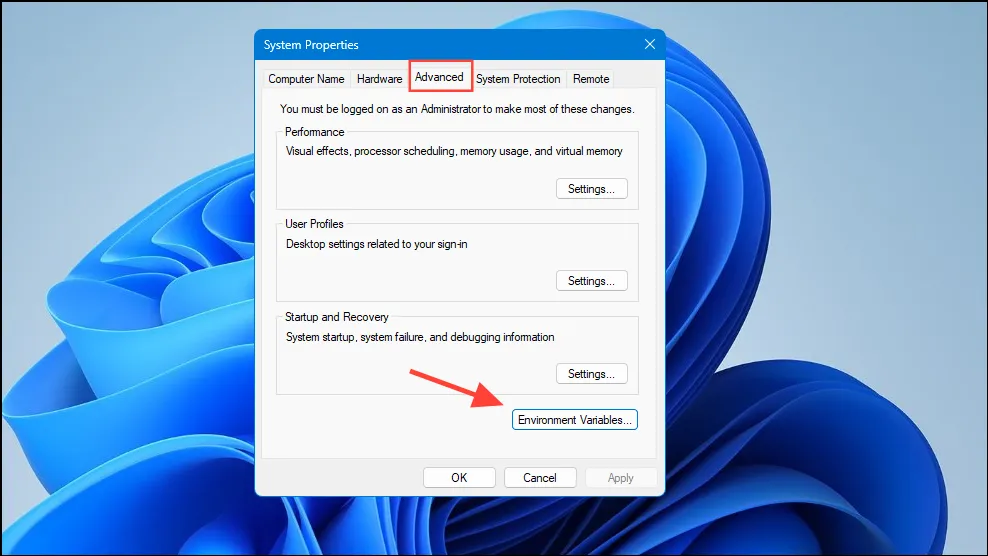

- Når dialogboksen Systemvariabler åpnes, klikker du på «Miljøvariabler»-knappen på «Avansert»-fanen.

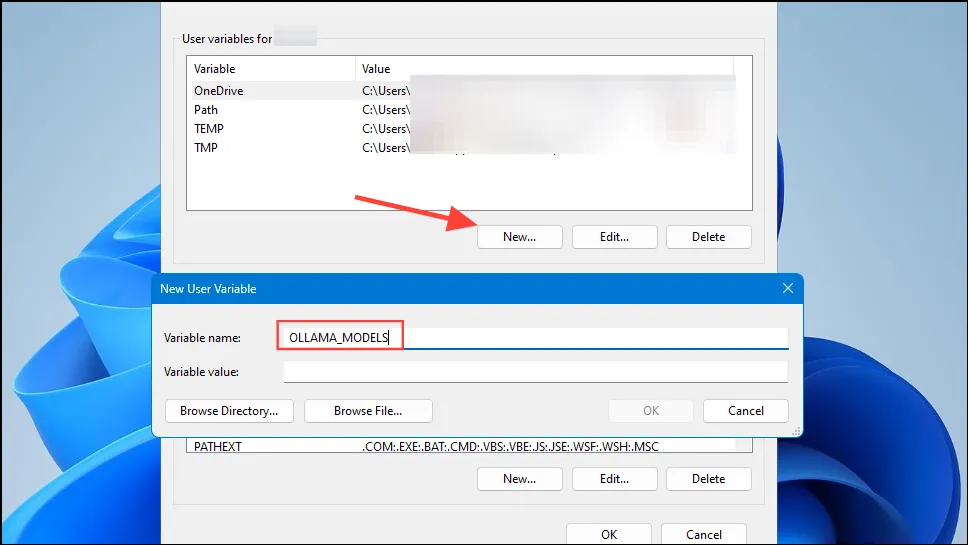

- Klikk på «Ny»-knappen for brukerkontoen din og lag en variabel som heter

OLLAMA_MODELSi feltet «Variabelnavn».

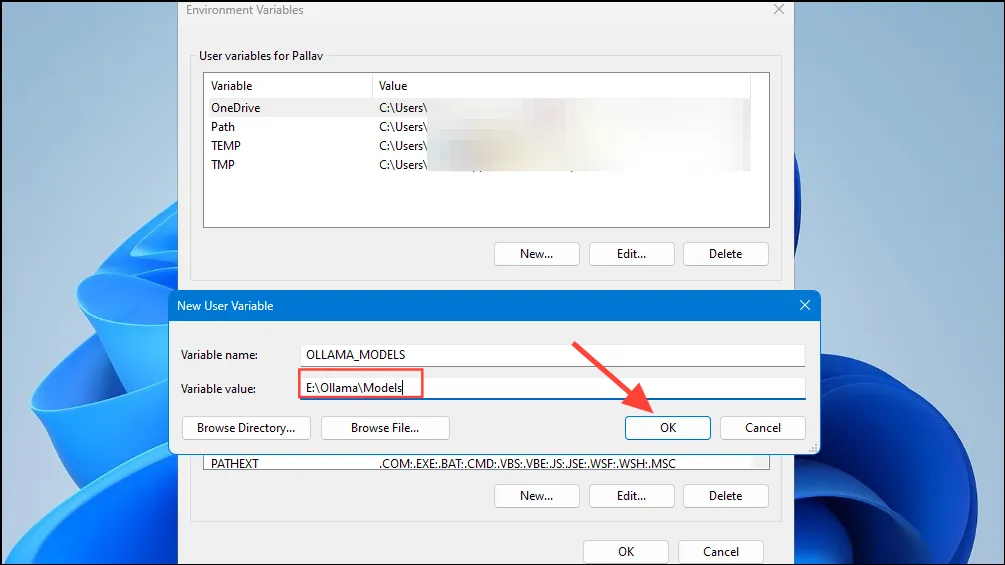

- Skriv deretter inn plasseringen til katalogen der du vil at Ollama skal lagre modellene sine i feltet «Variabel verdi». Klikk deretter på «OK»-knappen før du starter Ollama fra Start-menyen.

- Nå er du klar til å begynne å bruke Ollama, og du kan gjøre dette med Metas Llama 3 8B, den nyeste åpen kildekode AI-modellen fra selskapet. For å kjøre modellen, start en ledetekst, Powershell eller Windows Terminal-vindu fra Start-menyen.

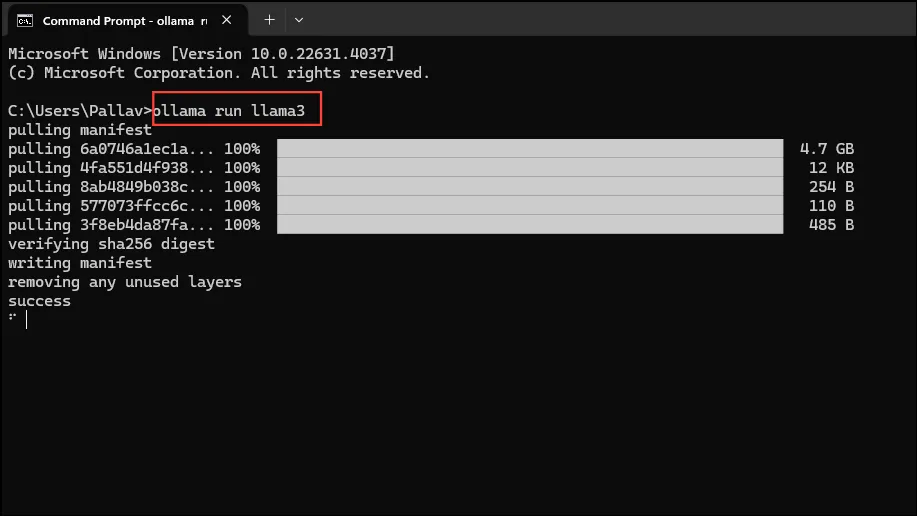

- Når ledetekstvinduet åpnes, skriv inn

ollama run llama3og trykk Enter. Modellen er nærmere 5 GB, så nedlastingen vil ta tid.

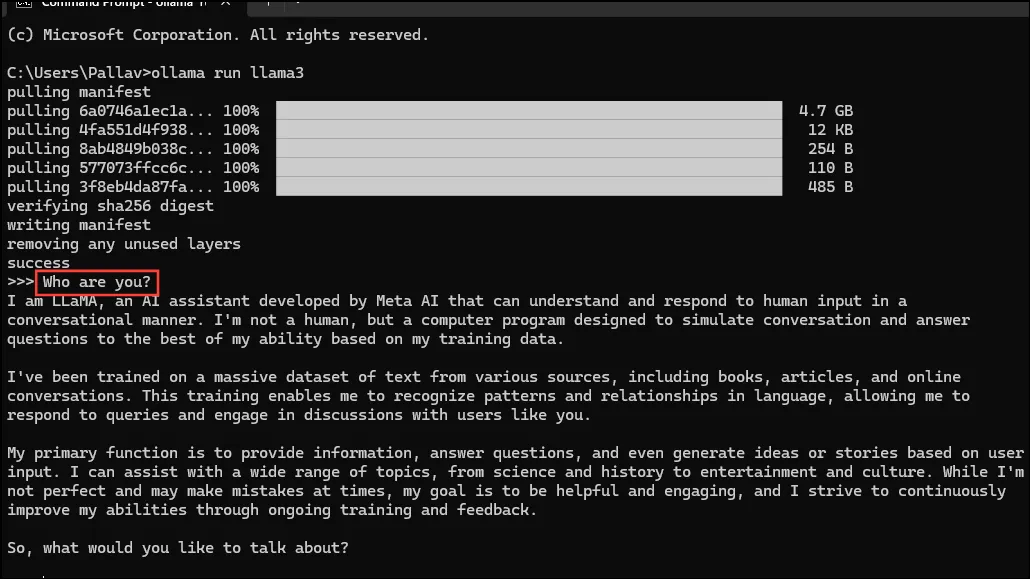

- Når nedlastingen er fullført, kan du begynne å bruke Llama 3 8B og snakke med den direkte i kommandolinjevinduet. Du kan for eksempel spørre modellen

Who are you?og trykke Enter for å få svar.

- Nå kan du fortsette samtalen og stille spørsmål til AI-modellene om ulike emner. Bare husk at Llama 3 kan gjøre feil og hallusinerer, så du bør være forsiktig når du bruker den.

- Du kan også prøve ut andre modeller ved å besøke Ollama modellbibliotek-siden. I tillegg er det forskjellige kommandoer du kan kjøre for å prøve ut forskjellige funksjoner som Ollama tilbyr.

- Du kan også utføre ulike operasjoner mens du kjører en modell, for eksempel å angi øktvariabler, vise modellinformasjon, lagre en økt og mer.

- Ollama lar deg også dra nytte av multimodale AI-modeller for å gjenkjenne bilder. For eksempel kan LLava-modellen gjenkjenne bilder generert av DALLE-3. Den kan beskrive bilder i detalj.

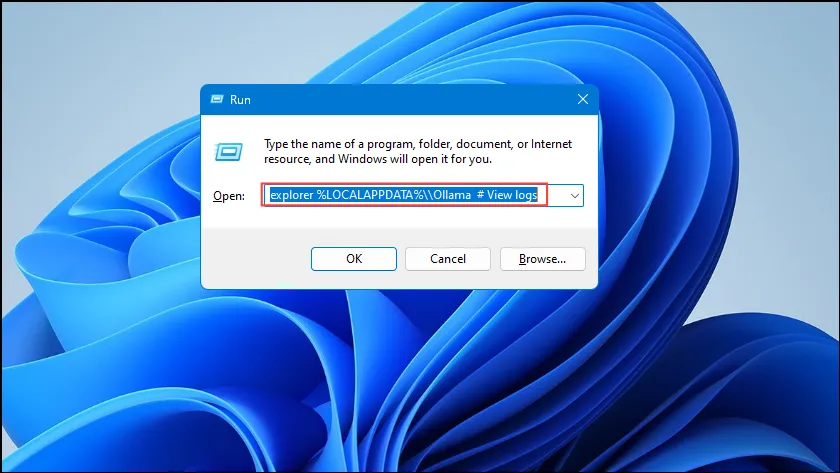

- Hvis du får feil mens du kjører Ollama, kan du sjekke loggene for å finne ut hva som er problemet. Bruk

Win + Rsnarveien for å åpne Kjør-dialogen og skriv deretterexplorer %LOCALAPPDATA%\\Ollama # View logsinn i den før du trykker Enter.

- Du kan også bruke andre kommandoer som

explorer %LOCALAPPDATA%\\Programs\\Ollamaogexplorer %HOMEPATH%\\.ollamafor å sjekke binærfiler, modell og konfigurasjonslagringsplassering.

Ting å vite

- Ollama oppdager automatisk GPU-en din for å kjøre AI-modeller, men i maskiner med flere GPUer kan den velge feil. For å unngå dette, åpne Nvidia-kontrollpanelet og sett skjermen til «Nvidia GPU Only».

- Skjermmodus er kanskje ikke tilgjengelig på alle maskiner og er også fraværende når du kobler datamaskinen til eksterne skjermer.

- På Windows kan du sjekke om Ollama bruker riktig GPU ved å bruke Task Manager, som vil vise GPU-bruk og fortelle deg hvilken som brukes.

- Selv om installasjon av Ollama på macOS og Linux er litt forskjellig fra Windows, er prosessen med å kjøre LLM-er ganske lik.

Legg att eit svar