På sin årlige I/O-konferanse i California kom Google med flere kunngjøringer knyttet til AI, inkludert nye modeller og oppgraderinger til eksisterende. En av de mest interessante kunngjøringene var Project Astra – en multimodal assistent som fungerer i sanntid og kombinerer evnene til Google Lens og Gemini for å gi deg informasjon fra omgivelsene dine.

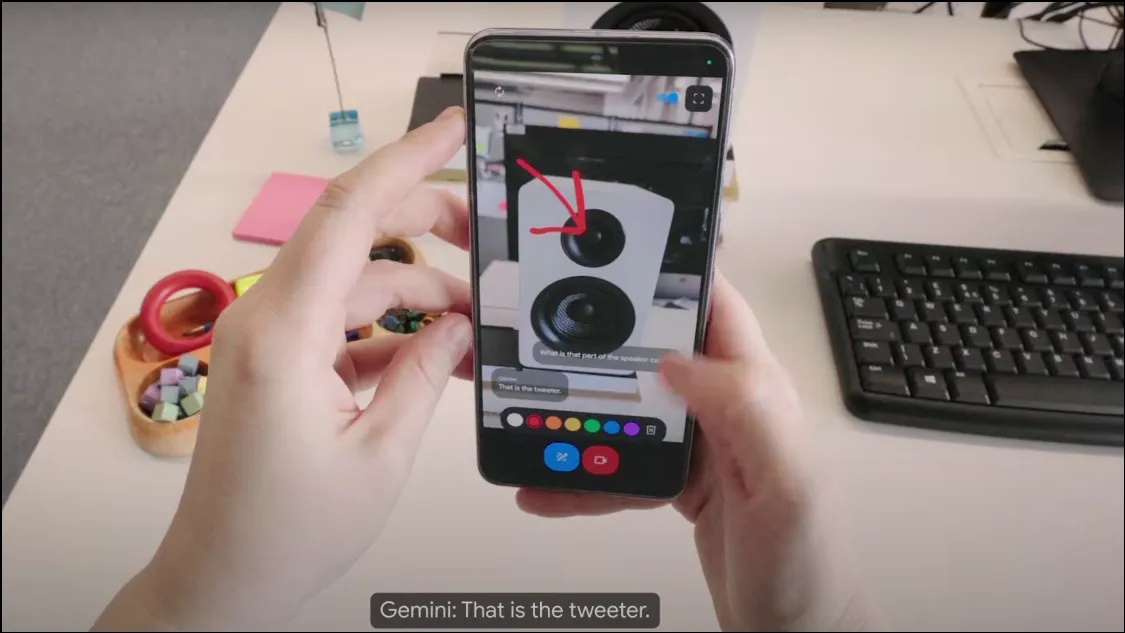

Hvordan fungerer Project Astra? På konferansen viste Google frem en tidlig versjon av Project Astra, som fungerer som en kamerabasert chatbot og kan samle informasjon fra omgivelsene dine ved hjelp av kameraet på enheten din. Som en multimodal AI-assistent kan den bruke lyd, video og bilder som innganger og gi nødvendig utgang basert på disse. Den kjører på Gemini 1.5 Pro-modellen, noe som gjør den utrolig kraftig.

Chatboten analyserer objekter og omgivelser i sanntid og kan svare veldig raskt på spørsmål, noe som gjør den ganske lik en menneskelig assistent, eller Tony Starks elskede JARVIS. Project Astra fungerer også med wearables som smarte briller, noe som betyr at det er mye potensial for AI-chatboten å integreres i forskjellige enheter.

Project Astra kan bedre forstå konteksten den brukes i, behandle informasjon raskere og beholde den for raskere tilbakekalling. Taleegenskapene er også mye forbedret sammenlignet med tidligere Gemini-modeller, så det høres mer naturlig og menneskelig ut.

Hva kan Project Astra gjøre? I den korte demoen som Google viste frem, virker det som om det er mye Project Astra kan hjelpe med å oppnå. Den kan observere og forstå objekter og steder gjennom kameralinsen og mikrofonen og gi deg informasjon om dem. Du kan for eksempel bare rette telefonen mot et stykke kode og diskutere det med chatboten, eller be den identifisere et objekt og bruken av det.

På samme måte, takket være posisjonsbevissthet, kan Project Astra gi informasjon om din lokalitet bare ved å ta en titt på omgivelsene dine. Den kan også beholde informasjon som vises til den, noe som kan være ganske nyttig hvis du vil finne feilplasserte gjenstander, som demonstrert i demoen da det hjalp brukeren med å finne brillene sine.

Du kan også be AI-assistenten om kreative ideer, akkurat som med Gemini på telefonen. Du kan for eksempel be den om å komme med tekster til en sang, et navn på et musikalsk band eller noe annet. I utgangspunktet har Project Astra som mål å være en universell AI-assistent som kan gi deg informasjon i sanntid på en veldig samtale måte.

Når vil Project Astra være tilgjengelig? Foreløpig har ikke Google kommet med kunngjøringer angående tilgjengeligheten av Project Astra. Versjonen som vises i demoen er en tidlig prototype, men Google antydet at disse egenskapene kan bli integrert i den eksisterende Gemini-appen på et senere tidspunkt.

Med Project Astra streber Google etter å lede utviklingen av AI-assistenter slik at de blir enda mer nyttige og enklere å bruke. Google er imidlertid ikke den eneste i jakten på dette målet. OpenAI kunngjorde også nylig GPT-4o, noe som gjør ChatGPT multimodal, noe som forbedrer evnene og effektiviteten. ChatGPTs nye stemmemodus (skal lanseres snart) kan også bruke videoinngang fra enhetens kamera mens du samhandler med brukere.

Akkurat nå er forskjellen mellom de to at GPT-4o snart vil være tilgjengelig på alle enheter som kjører ChatGPT, mens Project Astra forventes å være tilgjengelig som Gemini Live en gang i fremtiden, selv om det ikke er noen utgivelsesdato for øyeblikket. Med GPT-4o-drevet ChatGPT som er tilgjengelig tidligere, gjenstår det å se om Googles Project Astra vil være bra nok til å konkurrere med OpenAIs mer populære chatbot.

Legg att eit svar